A dieta do silício: a ascensão da IA Verde contra o gigantismo tecnológico

Durante décadas, a corrida pelo domínio da inteligência artificial foi pautada por um lema implacável: a precisão acima de tudo. Essa mentalidade, agora batizada de IA Vermelha, gerou avanços extraordinários, mas a um custo ambiental que a Terra começa a cobrar. Entre 2012 e 2019, o poder computacional exigido para treinar os maiores modelos de linguagem saltou 300 mil vezes. O resultado desse crescimento hiperbólico é uma pegada de carbono e um consumo hídrico que desafiam as metas globais de sustentabilidade. Como resposta, surge a IA Verde, uma filosofia de desenvolvimento que coloca a eficiência energética e a responsabilidade social no mesmo patamar da acurácia técnica.

O objetivo central dessa nova abordagem é harmonizar o progresso digital com os limites planetários. Não se trata apenas de reduzir a conta de luz dos grandes centros de dados, mas de repensar todo o ciclo de vida da tecnologia. Isso inclui desde o cuidado com a extração de metais raros para chips até o descarte responsável de hardware obsoleto. A IA Verde defende que um algoritmo só é verdadeiramente inteligente se for capaz de realizar sua tarefa com o menor rastro ecológico possível, utilizando técnicas de compressão e o compartilhamento de modelos já treinados para evitar o desperdício de processamento.

O rastro de sede e o calor das máquinas

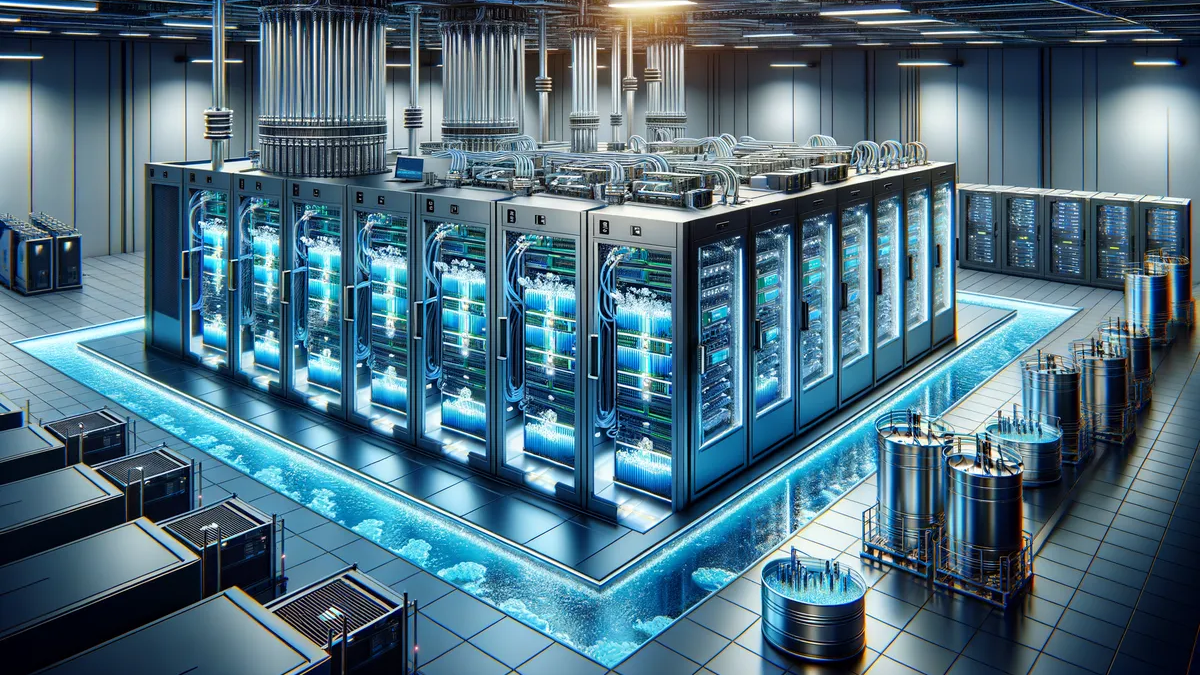

Um dos segredos mais bem guardados da indústria tecnológica é a quantidade de água necessária para manter os chatbots operando. Estima-se que apenas o treinamento do GPT-3, desenvolvido pela OpenAI, tenha devorado cerca de 700 mil litros de água limpa para o resfriamento das máquinas. Esse consumo hídrico é um ponto crítico, especialmente em regiões que já enfrentam escassez. Os data centers tradicionais, dependentes de sistemas de resfriamento a ar e torres de evaporação, perdem volumes massivos de água para a atmosfera, criando um conflito direto com as necessidades das comunidades locais.

Para mitigar esse impacto, a infraestrutura física está passando por uma revolução. O resfriamento líquido direto no chip aparece como a solução mais promissora. Ao utilizar fluidos com alta condutividade térmica, esses sistemas conseguem remover o calor de forma muito mais eficiente que as ventoinhas barulhentas do passado. Empresas que operam em nuvem, como a Microsoft através do Azure, têm demonstrado que essa transição não apenas economiza água por meio de circuitos fechados, mas também reduz o consumo de energia em cerca de 16% por servidor. Manter os processadores em temperaturas mais baixas e estáveis prolonga a vida útil do hardware e permite que as máquinas entreguem mais desempenho por cada watt consumido.

VEJA TAMBÉM: Gastronomia brasileira conquista o mundo com sabores amazônicos inesquecíveis

O custo oculto do raciocínio complexo

A eficiência da inteligência artificial também é decidida no design do código. Nem toda tarefa exige um modelo colossal com centenas de bilhões de parâmetros. Para funções simples de visão computacional, arquiteturas leves como a MobileNet, pensada para dispositivos móveis, mostram que é possível ter alta performance com um consumo de energia irrisório. No entanto, a tendência atual de modelos focados em raciocínio complexo, como o DeepSeek-R1 da DeepSeek, revela um lado preocupante. Essas ferramentas podem consumir até 65 vezes mais energia em uma única consulta longa do que modelos mais simples, como o LLaMA-3.1-8B da Meta.

Essa disparidade evidencia o efeito de escala: quanto mais parâmetros e camadas de raciocínio uma IA possui, maior é a sua fatura ambiental. A estratégia da IA Verde propõe o uso de técnicas como a quantização, que basicamente “arredonda” os números complexos do modelo para versões mais simples, reduzindo seu tamanho sem perdas perceptíveis de inteligência. Outra técnica essencial é o loteamento de tarefas; processar várias solicitações de uma vez em vez de uma por uma pode cortar o gasto energético pela metade. O desafio para os desenvolvedores em 2026 é saber quando usar um “canhão” tecnológico e quando uma solução leve e elegante é suficiente para resolver o problema do usuário.

O Brasil como porto seguro do processamento limpo

Se o hardware e o software definem o gasto de energia, a origem dessa eletricidade define o impacto climático. É aqui que a geografia se torna um fator competitivo. O mesmo modelo de inteligência artificial pode ter uma pegada de carbono dez vezes menor dependendo de onde seus servidores estão localizados. Regiões com matrizes elétricas baseadas em fontes renováveis tornam-se polos de atração para a “computação ciente do carbono”. O Brasil, com sua vasta produção de energia hidrelétrica, eólica e solar, posiciona-se como um dos locais mais estratégicos do mundo para hospedar a próxima geração de data centers verdes.

Além da matriz limpa, a técnica de agendamento inteligente permite que tarefas pesadas de treinamento sejam realizadas nos horários em que a rede elétrica está mais abastecida por fontes renováveis, como durante o pico de sol para a energia fotovoltaica. No entanto, especialistas alertam para o Paradoxo de Jevons: a história mostra que, sempre que tornamos um recurso mais eficiente e barato, acabamos consumindo mais dele. Se a IA se tornar tão eficiente que passarmos a usá-la para tarefas triviais e desnecessárias em escala massiva, os ganhos ambientais podem ser anulados. A sustentabilidade digital exige, portanto, não apenas inovação técnica, mas uma consciência coletiva sobre o valor real de cada clique no mundo virtual.

Você precisa fazer login para comentar.